Genauso wie die Algorithmen von Google und CO., entwickeln sich auch die SEO-Trends jedes Jahr ein wenig. Maßnahmen kommen hinzu, werden angepasst oder abgeschafft. Aber egal welche Tools zurzeit genutzt werden, die Maßnahmen lassen sich grundlegend in drei Kategorien einteilen: Die Onsite-, Onpage- und Offsite-Suchmaschinenoptimierung.

Während sich die Offsite-SEO auf Inhalte außerhalb der eigenen Seite konzentrieren, geht es bei den beiden anderen um den Aufbau der Website und ihre Inhalte. Was hat es mit diesen beiden Anwendungsgebieten auf sich und wie unterscheiden sich die doch ähnlichen Begriffe?

Onsite- und Onpage-SEO greifen ineinander und ergänzen sich

Eins voraus: Eine gute Suchmaschinenoptimierung besteht nie aus nur einem der drei Teilgebiete. Wer wirklich erfolgreich SEO betreiben möchte, sollte sie immer miteinander kombinieren. Das ist nicht nur wichtig, wenn es darum geht, Inhalte auf und außerhalb der eigenen Webseite zu bearbeiten. Auch die eng verbundenen Onsite- und Onpage-SEO-Strategien greifen ineinander und vervollständigen sich gegenseitig.

Menschen, die von der Onpage-Optimierung sprechen, reden häufig bereits über eine Kombination der beiden Begriffe. Das liegt daran, da sie beide auf der Gegenseite der Offpage-Optimierung liegen, die sich um Inhalte außerhalb der Webseite (beispielsweise Backlinks) dreht.

Für eine effektive Onpage-Optimierung gehört auch immer eine Onsite-Optimierung dazu. Um sie umzusetzen, müssen wir zunächst ein paar Fragen klären: Was ist Onpage-Optimierung, was ist Onsite-Optimierung und wie unterscheiden wir sie?

Was ist Onpage-Optimierung?

Meist liegt der größte Fokus in der SEO auf den Onpage-Maßnahmen. Bei ihr geht es darum, mit dem Inhalt und Layout jeder einzelnen Seite einer Website eine bessere Suchmaschinenranking-Platzierung zu erreichen.

Was gehört zur Onpage-SEO?

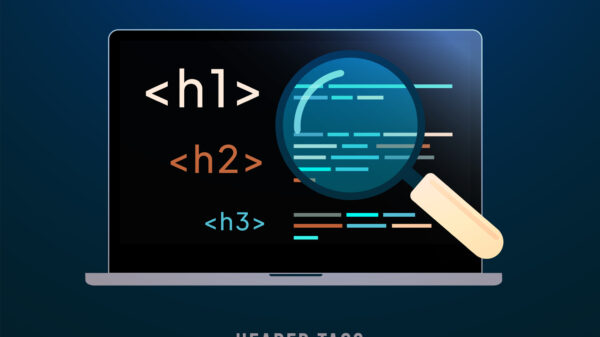

Bei der Onpage-SEO steht der Content an höchster Stelle. Hier untersucht der Algorithmus der Webseiten, ob das, was auf der Webseite dargestellt wird, zu dem Inhalt der Suchanfrage passt. Dazu gehören beispielsweise:

- Überschriften

- Textinhalte (z. B. Keywords, die zu den meistgenutzten Suchanfragen passen …)

- Textstruktur (z. B. Textlänge, Absatzanzahl, Hervorhebungen, Listen, Tabellen …)

- Medien (z. B. Bilder, Videos …)

- Social-Media-Verknüpfungen

- Metadaten (der Meta-Titel & die Meta-Description, die in Suchergebnissen als Titel und Beschreibung aufgelistet werden)

Was ist Onsite-Optimierung?

Die Onsite-Optimierung beschreibt weniger den Inhalt der Webseite, sondern ihren Aufbau. Hier geht es darum, eine klare, logische und aussagekräftige Struktur aufzubauen, die ein Nutzer und die Algorithmen leicht navigieren können.

Was gehört zur Onsite-SEO?

Die Onsite-SEO-Maßnahmen betreffen weniger die Inhalte einzelner Seiten, sondern eher eine websiteübergreifende Struktur. Oft betreffen sie eher das technische Grundgerüst als inhaltliche Faktoren. Dazu gehören:

- Übersichtliche Verlinkungen & Navigationsstruktur

- Aussagekräftige Dateinamen

- Fehlerfreier Code

- URL-Pfad-Definitionen

- Beschreibende URLs

- Sicherheitsprotokolle (HTTPS)

- und viele mehr …

Was gehört sowohl zur Onsite- als auch Onpage-SEO?

Einer der Gründe, aus denen Onsite- und Onpage-SEO häufig deckungsgleich genutzt werden, ist, dass manche der websitebezogenen Methoden sich nicht eindeutig zu einem oder dem anderen zuordnen lassen. Dazu gehören beispielsweise:

- Ob & wie gut die Crawler von Google auf die Seite zugreifen können

- Die Ladegeschwindigkeit

- Die Nutzerführung (beispielsweise durch ein Menü mit aussagekräftigen Titeln für weiterführende Links)

- Optimierung für mehrere Endgeräte

- Wie die Nutzer mit Inhalten interagieren können

Die technische SEO hat einen sehr großen Einfluss auf die Rankings

Auch wenn der Fokus vieler SEO-Ratgeber auf den Content-Optimierungen der Onpage-SEO liegt, sollte man die Onsite-SEO nicht vernachlässigen. Die technischen Aspekte und ein gutes Grundgerüst einer Website sind wichtige Einflüsse auf das Suchmaschinenranking.

Performance und Ladezeiten

Als Internetnutzer schreckt es uns ab, wenn Seiten lange laden müssen. Gerade bei Google-Suchen geht es häufig darum, schnell Informationen zu finden. Dabei überfliegen wir lieber Texte und suchen gezielt nach dem, was uns helfen kann, statt uns lange mit den Inhalten einer Seite zu beschäftigen.

Wenn eine Seite über einer Sekunde lang lädt, ist das bereits ein Grund für eine fallende Conversion-Rate. Die User rufen die Seite auf und verlassen sie schnell wieder, um auf der nächsten, hoffentlich schneller ladenden Webseite, nach den gewünschten Informationen zu suchen.

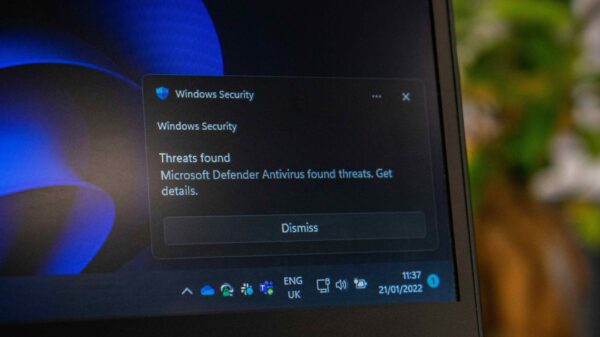

Sichere Datenübertragung

Sicherheit ist ein immer steigender Faktor in der digitalen Welt. Nach dem Wechsel von HTTP zu dem Sicherheitsprotokoll HTTPS nutzen User bevorzugt das HTTPS-Protokoll, da es Server authentifiziert und Daten beim Austausch verschlüsselt. Manche Webseiten, beispielsweise wenn die Zahlungsinformationen nach dem PCI-Standard erfassen, müssen HTTPS nutzen.

Google hat bereits 2014 angekündigt, dass das Vorhandensein des HTTPS-Protokolls ein Rankingfaktor sein wird. Auf den meisten Suchmaschinen werden die HTTP-Webseiten heute deutlich als unsicher markiert.

Mobilfreundlichkeit

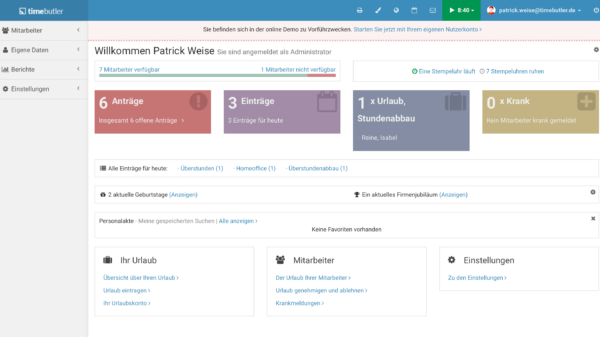

Google-Suchen finden selten ausschließlich am Heim-PC statt. Tablets und Handys sind handlicher und bieten sich für eine schnelle Suchanfrage an. Das gilt insbesondere für Local-SEO-Unternehmen. Bei diesen suchen viele Nutzer unterwegs nach Adressen, Öffnungszeiten und sonstigem.

Wer eine Webseite ohne Responsive Design hat, schneidet deshalb schlechter ab. Seit 2015 erhalten Webseiten von Google einen Vorteil, wenn sie als mobilfreundlich gelten. Seit 2019 gilt sogar der Mobile-First-Index, bei dem reine Empfehlungslisten aus Webseiten mit Mobilfreundlichkeit erstellt werden.

Responsive Design ist Webdesign, das sich an das Endgerät anpasst. Die Anordnung von Grafiken, die Länge von Texten, die Schriftgröße und vieles mehr sind entscheidend dafür, ob eine Webseite lesbar und navigierbar ist. Hat man eine Webseite, deren Layout nicht für einen kleinen Handybildschirm ausgelegt ist, kann das nicht nur schlecht aussehen, wenn sich alles verschiebt und auf den Bildschirm quetscht. Im schlimmsten Fall können Links nicht angeklickt oder Texte nicht vollständig gelesen werden.

Indexierbarkeit & Crawlability

Bevor Google und Co. ihren Usern eine Webseite überhaupt vorschlagen können, müssen sie sich darüber bewusst sein, dass diese Seite überhaupt existiert. Nur, weil man eine Webseite online stellt, heißt das nicht, dass sie auch von den Suchmaschinen gefunden wird. Wir müssen sichergehen, dass unsere Webseite für die Suchmaschinen-Bots auffindbar und lesbar ist.

Diese, beispielsweise die Crawler von Google, durchsuchen das Internet nach allen möglichen Inhalten, die sie dann erfassen und dem Google-Index hinzufügen. Dieser ist die Grundlage, die der Suchmaschinenalgorithmus nutzt, um eine passende Antwort zu einer Suchanfrage zu finden. Ist die eigene Webseite nicht Teil des Index, kann Google sie nicht auswerten, egal wie passend ihr Inhalt wäre.

Der erste Schritt ist es sicherzugehen, dass die Webseite und ihre wichtigen Dateien in ihrem Code nicht durch robots.txt gesperrt sind. Die Google Search Console hilft dabei zu erkennen, ob und welche Dateien einer Webseite nicht zugänglich sind. Danach geht es darum, den Code und die Seitenstruktur der Webseite für die Bots leicht lesbar zu gestalten. Das erreichen wir beispielsweise durch das Entfernen von doppelten Inhalten und eine klar etablierte Sitemap.

Fazit

Wenn es darum geht, eine Webseite user- und algorithmusfreundlich zu gestalten, können wir weder auf Onsite- noch auf Onpage-Optimierungen verzichten. Eine Seite mit gutem Content, aber einem schlechten technischen Grundgerüst ist genauso ungünstig wie eine Seite, deren Struktur & Performance zwar gut aufgestellt sind, die aber nur mangelhafte Inhalte trägt. Damit der Algorithmus der Suchmaschinen unsere Seite erfassen und ihre Inhalte als userfreundlich, hochwertig und nützlich bewerten kann, müssen wir von beiden Methoden Gebrauch machen.

Dass wir die Maßnahmen nicht immer auf eines der beiden Felder einteilen können, zeigt, dass die Strategien beider Teilbereiche der SEO oft symbiotisch arbeiten. Ein guter, klarer Inhalt und strukturierter Code helfen dabei, dass die Seite schnell lädt, leicht navigierbar ist und dem User einen Mehrwert gibt.

Viele gute Onpage- und Onsite-Methoden lassen sich bereits erkennen, wenn wir uns anschauen, was uns selbst wichtig ist, wenn wir eine Webseite aufrufen. Hat sie lange Ladezeiten und können wir uns dort nicht gut orientieren, da eine Nutzerführung fehlt, schreckt uns das ab. Umso eher achten wir dann darauf, dass ein Besucher sich auf unserer Seite immer zurechtfinden kann und ihre Performance zufriedenstellend ist.

Bei weniger offensichtlichen SEO-Faktoren hilft es, die Google-Guidelines zu lesen oder von den vielen guten SEO-Ratgeberquellen im Internet zu profitieren, die auch die Informationen haben, die Google selbst nicht rausgibt. Wer wirklich gutes SEO machen möchte, erhält durch eine Agentur eine Lösung, die genau auf den eigenen Service zugeschnitten ist.